OpenAI презентовал новую мультимодальную языковую модель GPT-4o. Она работает с текстом, звуком и визуальным контентом в реальном времени, принимает в качестве входных данных и генерирует обратно любую их комбинацию.

↑ На видео игра в камень-ножницы-бумагу, другие примеры показывают в пресс-релизе

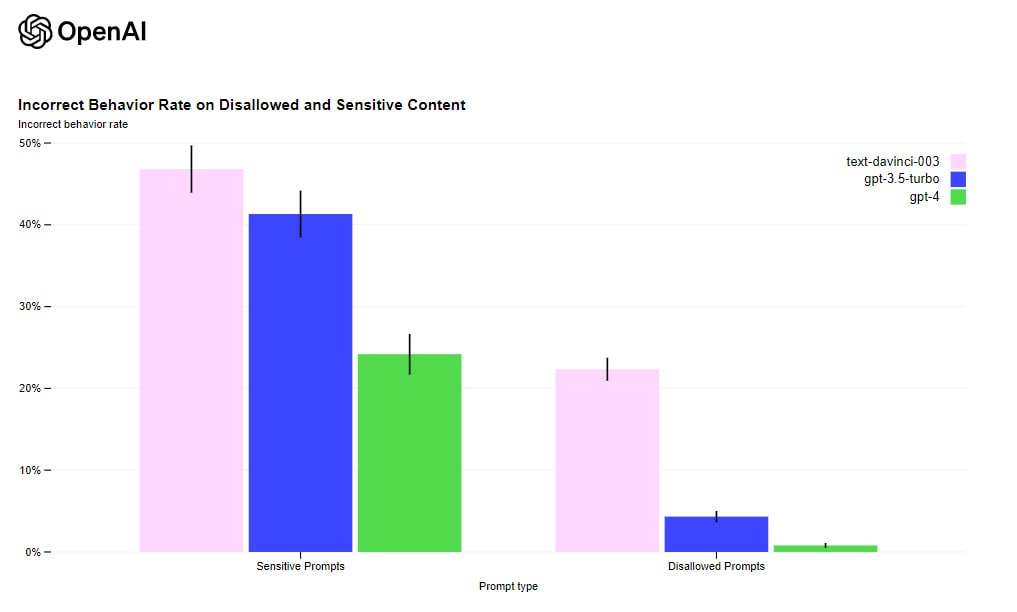

GPT-4o — наша первая модель, сочетающая в себе все эти параметры. Мы только начинаем изучать ее возможности и ограничения

GPT-4o распознает эмоции и может отвечать с любой интонацией, переводит онлайн, говорит не роботизированным человеческим голосом.

Сначала будет десктопное приложение для macOS, позже в 2024 году — для Windows. Доступ бесплатный, у платных пользователей — увеличенные лимиты.

Следите за нашими новостями в Телеграм и Яндекс.Дзен